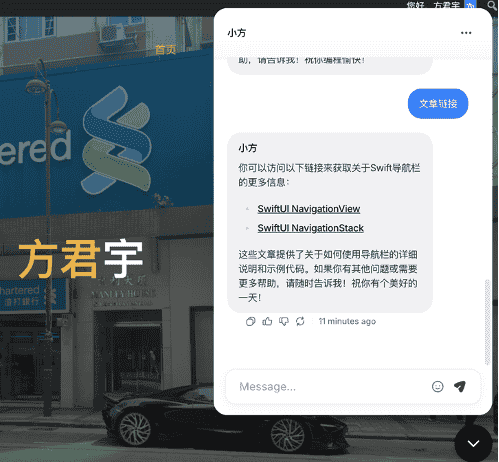

最近一位朋友告诉我,网站内容过多,查起来不友好,让我考虑给网站制作一个RAG知识库,之后,我使用Chatbase做了一个RAG知识库。

为什么有这种需求呢?是因为很多人希望网站能提供一个“智能客服”,回答FAQ,甚至能读懂站内文章。

训练一个大模型成本太高,就出现了“远程大模型 + 知识库 + 封装平台”的组合。

我把网站链接导入Chatbase,它自动帮我构建一个知识库,然后它再调用远程的大模型(比如OpenAI的4o Mini)来回答问题。

概念扫盲

1、远程大模型:指的是运行在云端的大语言模型(LLM)比如OpenAI GPT、Anthropic Claude、Google Gemini。

远程的意思是不在本地跑模型,而是通过API去调用,大模型是“核心大脑”,负责理解、生成回答。

2、RAG 知识库:RAG全称为Retrieval-augmented generation(检索增强生成)。

它不是模型本身,而是一种使用大模型的方法论。

思路是:

1)把网站文章、FAQ、PDF 切分成小段 → 存到向量数据库。

2)用户提问 → 系统先检索出相关内容。

3)把检索到的内容 + 用户问题 → 一起丢给远程大模型。

4)大模型生成更贴近资料的答案。

所以,RAG 知识库相当于给远程大模型加了一层“外挂记忆”。

3、AI 代理:在大模型和知识库之上,能做决策、调用工具的“秘书”(执行层)。

不仅可以对话、还可以调用工具、执行任务、做决策。

例如,帮我优化Xcode中的Swift代码,AI代理:

1)通过接口获取Xcode中的Swift代码。

2)调用RAG知识库→ 检索相关开发文档。

3)让大模型根据知识库内容生成优化建议。

4)调用本地API,将优化后的代码写回Xcode。

产品介绍

官方定制

OpenAI GPTs:上传文档、添加模型说明,变成一个“定制机器人”,官方支持,但只能在 ChatGPT 内使用。

RAG 知识库 SaaS 平台

Chatbase、Dify、Claude Workflows:上传文档/网站,它们自动建立RAG知识库,再把用户的问题交给大模型。

无需代码,上手快,适合网站 FAQ、客服场景。缺点是依赖平台。

开源/开发者工具

Flowise:可视化拖拽式,自部署。

LangChain / LlamaIndex:偏开发者,使用Python/JS写代码进行搭建,自由度高,适合工程师,缺点是需要编程能力。

聊天机器人平台

BotPress、Typebot:偏流程设计,起点不是大模型,而是“对话流程设计器”,能接入 LLM。适合做多步骤的问答/引导(比如:先问用户名称 → 再问需求 → 给推荐)。

使用场景

个人站点博主:Chatbase、Dify,省事。

中小企业客服:BotPress/Typebot + RAG 平台,能做多轮对话。

开发者/极客:LangChain/LlamaIndex,自由度高,可控。

有预算的大公司:自部署 Flowise + 私有模型,更安全。

相关链接

1、Chatbase:https://www.chatbase.co/

2、Open GPTs:https://openai.com/index/introducing-gpts/

3、Chatbase:https://www.chatbase.co/

4、Dify:https://dify.ai/

5、Claude Workflows:https://docs.anthropic.com/en/docs/claude-code/common-workflows

6、Flowise:https://flowiseai.com/

7、LangChain:https://www.langchain.com/

8、LlamaIndex:https://www.llamaindex.ai/

9、Botpress:https://botpress.com/

10、Typebot: https://typebot.io/